I riassunti , gli appunti i testi contenuti nel nostro sito sono messi a disposizione gratuitamente con finalità illustrative didattiche, scientifiche, a carattere sociale, civile e culturale a tutti i possibili interessati secondo il concetto del fair use e con l' obiettivo del rispetto della direttiva europea 2001/29/CE e dell' art. 70 della legge 633/1941 sul diritto d'autore

Le informazioni di medicina e salute contenute nel sito sono di natura generale ed a scopo puramente divulgativo e per questo motivo non possono sostituire in alcun caso il consiglio di un medico (ovvero un soggetto abilitato legalmente alla professione).

Caso e probabilità

La teoria della probabilità nasce dal desiderio di formulare previsioni matematiche sul futuro andamento di un fenomeno avendo a disposizione certi dati numerici di base.

Tutto ha origine dall’idea di assegnare ad un certo evento X un valore compreso fra 0 e 1, che misura la “probabilità” che lo stesso X si verifichi: questo numero, che indicheremo con p=p(X), è 0 se X è un evento impossibile, 1 se X è un evento certo. In generale X si verificherà in determinate circostanze (casi favorevoli), che saranno solo una parte di tutti i casi possibili; p misura precisamente la proporzione dei casi favorevoli rispetto ai casi possibili. Se si lancia una moneta non truccata, è intuitivo associare la probabilità p=0,5 all’evento X che corrisponde al risultato “testa”; per simmetria, all’evento complementare X' spetterà la probabilità q=0,5. Se la moneta non è perfettamente bilanciata, in assenza di altre informazioni, si può dire solamente che agli eventi X e X' spettano, nell’ordine, probabilità p e q soggette alla condizione p+q=1. Infatti i casi possibili sono formati dai casi favorevoli a “testa” e dai casi favorevoli a “croce”, che, insieme, danno luogo ad un evento certo (perché sicuramente uscirà testa o uscirà croce). In generale, sia dato un numero n di eventi X1, X2,…, Xn, di probabilità p1, p2,…, pn. Chiamiamo X l’evento in cui uno tra X1, X2,…, Xn, si verifica: qui supponiamo che tali eventi si escludano a vicenda. Il calcolo dei casi favorevoli a X mostra subito che la probabilità di X sarà data dalla formula

p = p1 + p2 + … + pn,

![]() detta della probabilità totale. L’evento X potrebbe essere, ad esempio, l’estrazione di una pallina di colore chiaro dall’urna raffigurata. Esso si compone degli eventi X1, X2 e X3, corrispondenti all’estrazione di una pallina rosa, una pallina celeste, un pallina gialla; le rispettive probabilità sono p1=3/11, p2=1/11, p3=2/11. Sommando, si ottiene p= 6/11: in effetti, una pallina chiara si estrae in 6 casi su 11 possibili.

detta della probabilità totale. L’evento X potrebbe essere, ad esempio, l’estrazione di una pallina di colore chiaro dall’urna raffigurata. Esso si compone degli eventi X1, X2 e X3, corrispondenti all’estrazione di una pallina rosa, una pallina celeste, un pallina gialla; le rispettive probabilità sono p1=3/11, p2=1/11, p3=2/11. Sommando, si ottiene p= 6/11: in effetti, una pallina chiara si estrae in 6 casi su 11 possibili.

Supponiamo ora invece di voler effettuare tre estrazioni successive, rimettendo ogni volta la pallina estratta nell’urna, e di voler calcolare la probabilità che esca prima una pallina rosa, poi una celeste, infine un pallina gialla. Le combinazioni vincenti sono quelle formate da una delle tre palline rosa, dall’unica pallina celeste, e da una delle due palline gialle. I casi favorevoli al nuovo evento X desiderato si otterranno quindi moltiplicando tra loro i casi in cui la prima volta esce il rosa, i casi in cui la seconda volta esce il celeste ed i casi in cui la terza volta esce il giallo: la probabilità di X sarà il prodotto delle probabilità p1, p2 e p3. In generale, se l’evento X prevede che certi eventi X1, X2,…, Xn si verifichino tutti, in maniera indipendente, la sua probabilità sarà

p = p1 · p2 · … · pn

detta probabilità composta.

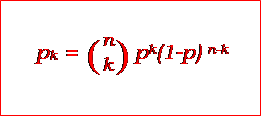

La probabilità totale e la probabilità composta vengono utilizzate, sia pur implicitamente, nelle lettere che, alla metà del Seicento, Pascal e Fermat si scambiarono a proposito di un problema di spartizione della posta tra due giocatori. Successivamente Jakob Bernoulli scoprì una formula generale che permette di calcolare, ad esempio, la probabilità pk che, su n partite disputate tra due giocatori, di cui uno vince con probabilità p, questi ne vinca esattamente k:

Vi compare il coefficiente binomiale “n su k”, presente nel triangolo aritmetico: un evento cui si applica la formula si dice retto da una distribuzione binomiale. Per “distribuzione” si intende il modo in cui la probabilità totale 1 di tutti i possibili esiti del gioco si ripartisce tra questi ultimi. Essa può essere efficacemente visualizzata con un istogramma.

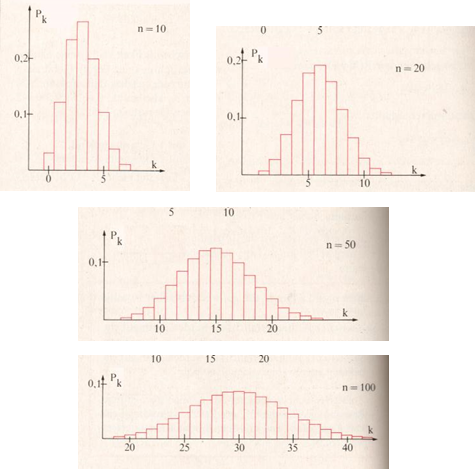

Nei quattro esempi raffigurati abbiamo fissato p=0,3, scegliendo per n i valori 10, 20, 50 e 100. Sull’asse orizzontale sono riportati i possibili valori di k, e verticalmente le corrispondenti probabilità pk. Non si può fare a meno di notare che, al crescere di n, il diagramma tende ad assumere una forma sempre più simmetrica.

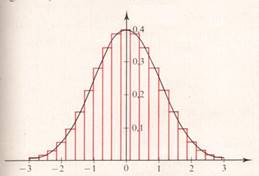

In effetti, al limite, il suo profilo coincide con il grafico di una particolare funzione, detta campana di Gauss.

In effetti, al limite, il suo profilo coincide con il grafico di una particolare funzione, detta campana di Gauss.

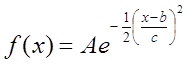

La sua espressione è del tipo

La sovrapposizione rappresentata in figura può essere facilmente realizzata traslando l’istogramma e cambiando l’unità di misura sull’asse orizzontale secondo valori numerici prestabiliti. Attraverso questa trasformazione, è possibile allora ricavare, dalla campana di Gauss, valori approssimati per le probabilità pk.

Quando il numero n è grandissimo, il grafico della funzione sostituisce, in modo naturale, l’istogramma. Allora il fenomeno che si studia cessa di essere una successione discreta dieventi valutabili singolarmente, per divenire un insieme continuo di cui si possono esaminare porzioni di varia estensione, ciascuna rappresentata da un intervallo sull’asse delle ascisse. Ciò è quanto avviene, ad esempio, se si vuole rappresentare graficamente la distribuzione delle velocità delle particelle che compongono un gas in condizioni di equilibrio. (moto browniano). Non si potrà certo determinare direttamente la probabilità che, pescando a caso una particella, questa abbia una data velocità, ma si potrà stimare la proporzione delle particelle la cui velocità è vicina ad un certo valore.

La Meccanica Statistica ci insegna che il moto browniano è retto da una distribuzione gaussiana. Questa legge empirica permette di prevedere, dato un certo volume di gas ad una certa temperatura, i risultati dell’esperimento, puramente ipotetico, in cui si misurassero le velocità di un gran numero di particelle “prelevate” dal gas. Ci si aspetterebbe, in particolare, di incontrare, con maggior frequenza, le velocità prossime al valore “centrale”.

D’altra parte, come abbiamo visto, la distribuzione gaussiana è una sorta di corrispettivo continuo della distribuzione binomiale. Viene allora naturale chiedersi se anche quest’ultima rispecchi i risultati che ci si deve concretamente aspettare, ad esempio, da n lanci di una moneta. L’esperienza (oltre che l’intuizione) fornisce una risposta affermativa, anche se solo al limite: la proporzione m/n di risultati “testa” tende infatti a coincidere con la probabilità p=0,5, e ciò è tanto più vero quanto più grande è n (e quanto più, allora, la distribuzione binomiale si avvicina alla distribuzione gaussiana). Questo è l’enunciato della legge dei grandi numeri, così enunciata da Bernoulli:

Se p è la probabilità costante di un evento in una prova, e se, su n prove eseguite, m risultano favorevoli all’evento, la probabilità che risulti |p-m/n| < tende a 1 quando n tende all’infinito, comunque sia prefissato >0.

Le n prove eseguite potrebbero essere anche, ad esempio, le ripetute misurazioni di una stessa grandezza fisica con lo stesso strumento. Se quest’ultimo è ragionevolmente affidabile, i valori misurati con maggiore frequenza saranno quelli vicini al valore reale. Più precisamente, la distribuzione dei valori misurati sarà, con buona approssimazione, gaussiana: per ovvie ragioni di simmetria sarà dunque perfettamente lecito stimare il valore reale formando la media aritmetica dei valori misurati, dopo aver eventualmente scartato quelli più “devianti”. La campana di Gauss nasce, in effetti, come rappresentazione degli errori di misura.

Con la legge dei grandi numeri e la distribuzione gaussiana i matematici sono riusciti a scoprire, in un insieme apparentemente casuale e disordinato di eventi - un processo aleatorio- una regolarità che permette di imbrigliarli in una teoria generale, e di dominarli con facili strumenti numerici. Il termine gas venne coniato nel Seicento sul modello della parola greca caos: i risultati ottenuti nei secoli seguenti mostrarono, però, che i gas non potevano essere propriamente considerati il regno della confusione. Se caos c’è, questo è da considerarsi un caos benigno. Esistono invece altri fenomeni, anche macroscopici, che si sottraggono, in misura più o meno accentuata, alle leggi viste nella sezione precedente: l’andamento dei titoli di Borsa, il profilo di coste e montagne, e persino la sequenza delle piene del Nilo (l’imperscrutabile alternanza di periodi di “vacche magre” e di “vacche grasse” di biblica memoria). Questi sono tutti esempi di quello che potremmo chiamare caos selvaggio. Uno stadio intermedio è rappresentato da quegli eventi in cui l’approssimazione gaussiana comincia a delinearsi solo dopo un numero altissimo di iterazioni: ciò avviene in tempi estremamente lunghi, che spesso superano la durata stessa del processo: si può parlare allora di caos lento. La distinzione fra i tre livelli di caos risale a Mandelbrot, che, negli anni cinquanta, si era accorto come i fenomeni più ribelli non potessero essere domati con un approccio matematico classico. L’istogramma che raffigura la distribuzione di probabilità in n lanci di monete, visto da lontano, si confonde con la campana di Gauss. Così accade che il filo seghettato di un coltello ci appaia rettilineo: esiste una direzione ben precisa che prevale, come andamento complessivo, sulle piccole irregolarità del percorso. In maniera analoga, il flusso di corrente in un filo di rame è caratterizzato da continue oscillazioni: se nel circuito si inserisce un altoparlante, si ode un rumore confuso; se si collega un amperometro, invece, la sua lancetta segna un’intensità ben precisa e costante. Questi sono due casi di caos benigno che, come dice Mandelbrot, “fanno piacere a Descartes, dando la possibilità di decomporre la difficoltà: si studia dapprima la tendenza (che qui è rettilinea) e poi vi si sovrappongono le fluttuazioni.”

Questo metodo fallisce, invece, se si tenta di applicarlo alla costa della Bretagna: se se ne traccia il contorno da quote differenti, il risultato è una serie di disegni molto diversi, che non possono essere approssimati con una stessa forma “limite”. Lo stesso dicasi per certi diagrammi raffiguranti le fluttuazioni dei prezzi.

Mandelbrot scoprì in queste forme, che sembrano arbitrariamente irregolari, un importante tratto comune, che chiamò autoaffinità, e che mise a fondamento di una nuova geometria, la geometria frattale.

Matematica e Psicologia: La probabilità soggettiva

Fonte: http://www.dm.uniba.it/ipertesto/leibniz_pascal/caso.doc

Sito web da visitare: http://www.dm.uniba.it/

Autore del testo: non indicato nel documento di origine

Il testo è di proprietà dei rispettivi autori che ringraziamo per l'opportunità che ci danno di far conoscere gratuitamente i loro testi per finalità illustrative e didattiche. Se siete gli autori del testo e siete interessati a richiedere la rimozione del testo o l'inserimento di altre informazioni inviateci un e-mail dopo le opportune verifiche soddisferemo la vostra richiesta nel più breve tempo possibile.

I riassunti , gli appunti i testi contenuti nel nostro sito sono messi a disposizione gratuitamente con finalità illustrative didattiche, scientifiche, a carattere sociale, civile e culturale a tutti i possibili interessati secondo il concetto del fair use e con l' obiettivo del rispetto della direttiva europea 2001/29/CE e dell' art. 70 della legge 633/1941 sul diritto d'autore

Le informazioni di medicina e salute contenute nel sito sono di natura generale ed a scopo puramente divulgativo e per questo motivo non possono sostituire in alcun caso il consiglio di un medico (ovvero un soggetto abilitato legalmente alla professione).

"Ciò che sappiamo è una goccia, ciò che ignoriamo un oceano!" Isaac Newton. Essendo impossibile tenere a mente l'enorme quantità di informazioni, l'importante è sapere dove ritrovare l'informazione quando questa serve. U. Eco

www.riassuntini.com dove ritrovare l'informazione quando questa serve